Analýza citlivosti - Sensitivity analysis

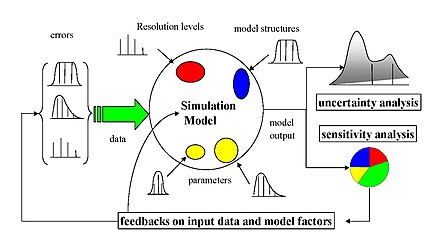

Analýza citlivosti je studie o tom, jak lze nejistotu ve výstupu matematického modelu nebo systému (numerického nebo jiného) rozdělit a rozdělit na různé zdroje nejistoty v jeho vstupech. Související praxí je analýza nejistoty , která se více zaměřuje na kvantifikaci nejistoty a šíření nejistoty ; v ideálním případě by měla být analýza nejistoty a citlivosti prováděna v tandemu.

Proces přepočítávání výsledků podle alternativních předpokladů ke stanovení dopadu analýzy proměnné na základě citlivosti může být užitečný pro řadu účelů, včetně:

- Testování robustnosti výsledků modelu nebo systému za přítomnosti nejistoty.

- Lepší porozumění vztahům mezi vstupními a výstupními proměnnými v systému nebo modelu.

- Snížení nejistoty prostřednictvím identifikace modelových vstupů, které způsobují významnou nejistotu ve výstupu, a proto by měly být středem pozornosti za účelem zvýšení robustnosti (možná dalším výzkumem).

- Hledání chyb v modelu (setkáním s neočekávanými vztahy mezi vstupy a výstupy).

- Zjednodušení modelu - oprava vstupu modelu, který nemá žádný vliv na výstup, nebo identifikace a odstranění nadbytečných částí struktury modelu.

- Posílení komunikace od modelářů k osobám s rozhodovací pravomocí (např. Tím, že doporučení budou důvěryhodnější, srozumitelnější, přesvědčivější nebo přesvědčivější).

- Hledání oblastí v prostoru vstupních faktorů, pro které je výstup modelu buď maximální nebo minimální nebo splňuje nějaké optimální kritérium (viz optimalizace a filtrování Monte Carlo).

- V případě kalibrace modelů s velkým počtem parametrů může primární test citlivosti usnadnit fázi kalibrace zaměřením na citlivé parametry. Neznalost citlivosti parametrů může mít za následek zbytečné trávení času na necitlivých.

- Snažit se identifikovat důležitá spojení mezi pozorováními, vstupy modelů a předpověďmi nebo prognózami, což vede k vývoji lepších modelů.

Přehled

Matematický model (například v biologii, změny klimatu, ekonomického nebo inženýrství), může být velmi složité, a v důsledku toho jeho vztahy mezi vstupy a výstupy mohou být špatně pochopen. V takových případech lze na model pohlížet jako na černou skříňku , tj. Výstup je „neprůhlednou“ funkcí jeho vstupů. Poměrně často jsou některé nebo všechny vstupy modelu vystaveny zdrojům nejistoty , včetně chyb měření , nedostatku informací a špatného nebo částečného porozumění hnacím silám a mechanismům. Tato nejistota omezuje naši důvěru v odezvu nebo výstup modelu. Dále se modely možná budou muset vyrovnat s přirozenou vnitřní variabilitou systému (aleatory), jako je výskyt stochastických událostí.

Správná modelová praxe vyžaduje, aby modelář poskytl hodnocení důvěry v model. To vyžaduje zaprvé kvantifikaci nejistoty ve všech modelových výsledcích ( analýza nejistoty ); a za druhé, vyhodnocení toho, do jaké míry každý vstup přispívá k nejistotě výstupu. Analýza citlivosti řeší druhý z těchto problémů (ačkoli analýza nejistoty je obvykle nezbytným předchůdcem), přičemž plní úlohu řazení podle důležitosti síly a relevance vstupů při určování variací výstupu.

V modelech zahrnujících mnoho vstupních proměnných je citlivostní analýza zásadní složkou vytváření modelů a zajišťování kvality. Vnitrostátní a mezinárodní agentury zapojené do studií posouzení dopadů zahrnly do svých pokynů oddíly věnované analýze citlivosti. Příkladem je Evropská komise (viz např. Pokyny pro posuzování dopadů ), Úřad pro rozpočet a rozpočet Bílého domu , Mezivládní panel pro změnu klimatu a modelovací pokyny Agentury USA pro ochranu životního prostředí . V komentáři publikovaném v roce 2020 v časopise Nature 22 vědci berou COVID-19 jako příležitost navrhnout pět způsobů, jak zajistit, aby modely sloužily společnosti lépe. Jedním z pěti doporučení pod nadpisem „Mind the assumpitions“ je „provádět analýzy globální nejistoty a citlivosti [...] a umožnit, aby se vše, co je nejisté - proměnné, matematické vztahy a okrajové podmínky, měnilo současně v průběhu model produkuje řadu předpovědí. '

Nastavení a omezení

Volba metody analýzy citlivosti je obvykle dána řadou problémových omezení nebo nastavení. Některé z nejběžnějších jsou

-

Výpočetní náklady: Analýza citlivosti se téměř vždy provádí spuštěním modelu (možná velkým) několikrát, tj. Přístupem založeným na vzorkování . To může být značný problém, když

- Jeden běh modelu zabere značné množství času (minuty, hodiny nebo déle). U velmi složitých modelů to není nic neobvyklého.

- Model má velké množství nejistých vstupů. Analýza citlivosti je v podstatě zkoumáním vícerozměrného vstupního prostoru , který exponenciálně roste s počtem vstupů. Podívejte se na kletbu dimenzionality .

- Výpočetní náklady jsou problémem mnoha praktických analýz citlivosti. Některé metody snižování výpočetních nákladů zahrnují použití emulátorů (pro velké modely) a screeningové metody (pro snížení dimenzionality problému). Další metodou je použití metody analýzy citlivosti založené na událostech pro výběr proměnných pro časově omezené aplikace. Toto je metoda výběru vstupní proměnné (IVS), která shromažďuje informace o stopách změn v systémových vstupech a výstupech pomocí analýzy citlivosti k vytvoření matice spouště/události spouště/vstupů, která je navržena tak, aby mapovala vztahy mezi vstupními daty jako příčiny které spouští události a výstupní data, která popisují skutečné události. Vztah příčina-následek mezi příčinami změny stavu, tj. Vstupními proměnnými a výstupními parametry efektového systému, určuje, která sada vstupů má skutečný dopad na daný výstup. Metoda má oproti analytické a výpočetní metodě IVS jasnou výhodu, protože se snaží pochopit a interpretovat změnu stavu systému v co nejkratším čase s minimální výpočetní režií.

- Korelované vstupy: Většina běžných metod analýzy citlivosti předpokládá nezávislost mezi vstupy modelu, ale někdy mohou být vstupy silně korelovány. Toto je stále nezralá oblast výzkumu a definitivní metody teprve budou stanoveny.

- Nelineárnost: Některé přístupy k analýze citlivosti, například přístupy založené na lineární regresi , mohou nepřesně měřit citlivost, když je odezva modelu nelineární s ohledem na její vstupy. V takových případech jsou vhodnější opatření založená na rozptylech .

- Interakce modelu: K interakcím dochází, když odchylka dvou nebo více vstupů současně způsobí rozdíly ve výstupu větší, než je změna každého ze samotných vstupů. Takové interakce jsou přítomny v jakémkoli modelu, který není aditivní , ale budou opomíjeny metodami, jako jsou scatterplots a one-a-a-time perturbations. Účinek interakcí lze měřit pomocí indexu citlivosti celkového řádu .

- Vícenásobné výstupy: Prakticky všechny metody analýzy citlivosti berou v úvahu jediný výstup univariačního modelu, přesto mnoho modelů vydává velké množství možná prostorově nebo časově závislých dat. Všimněte si toho, že to nevylučuje možnost provádět různé analýzy citlivosti pro každý požadovaný výstup. U modelů, ve kterých jsou výstupy v korelaci, je však obtížné interpretovat opatření citlivosti.

- Daná data: Zatímco v mnoha případech má odborník přístup k modelu, v některých případech musí být provedena analýza citlivosti s „danými daty“, tj. Tam, kde nelze vybrat body vzorku (hodnoty vstupů modelu pro každý běh) analytik. K tomu může dojít, když je třeba provést analýzu citlivosti retrospektivně, například pomocí dat z optimalizace nebo analýzy nejistoty, nebo když data pocházejí z diskrétního zdroje.

Předpoklady vs. závěry

V analýze nejistoty a citlivosti existuje zásadní kompromis mezi tím, jak je analytik při zkoumání vstupních předpokladů pečlivý a jak široký může být výsledný závěr . Tento problém dobře ilustruje ekonometrik Edward E. Leamer :

Navrhl jsem formu organizované analýzy citlivosti, kterou nazývám „globální analýza citlivosti“, ve které je vybráno okolí alternativních předpokladů a identifikován odpovídající interval závěrů. Závěry jsou považovány za solidní, pouze pokud je okolí předpokladů dostatečně široké, aby bylo věrohodné, a odpovídající interval závěrů je dostatečně úzký, aby byl užitečný.

Všimněte si, že Leamer při výběru předpokladů zdůrazňuje potřebu „důvěryhodnosti“. Nejsnadnějším způsobem, jak zneplatnit model, je prokázat, že je křehký s ohledem na nejistotu v předpokladech, nebo ukázat, že jeho předpoklady nebyly vzaty „dostatečně široko“. Stejný koncept vyjadřuje Jerome R. Ravetz, pro kterého je špatné modelování tím, že musí být potlačeny nejistoty ve vstupech, aby se výstupy staly neurčitými.

Nástrahy a potíže

Mezi některé běžné potíže při analýze citlivosti patří

- Příliš mnoho vstupů modelu k analýze. Screening lze použít ke snížení dimenzionality. Dalším způsobem, jak se vypořádat s kletbou dimenzionality, je použít vzorkování na základě nízkých nesrovnalostí

- Spuštění modelu trvá příliš dlouho. Emulátory (včetně HDMR ) mohou zkrátit celkový čas zrychlením modelu nebo snížením počtu potřebných spuštění modelu.

- K vybudování rozdělení pravděpodobnosti pro vstupy není dostatek informací. Distribuce pravděpodobnosti může být vytvořena na základě odborného posouzení , i když i tehdy může být obtížné budovat distribuce s velkou jistotou. Subjektivita rozdělení pravděpodobnosti nebo rozsahů silně ovlivní analýzu citlivosti.

- Nejasný účel analýzy. Na problém jsou aplikovány různé statistické testy a opatření a získává se hodnocení podle různých faktorů. Test by místo toho měl být přizpůsoben účelu analýzy, např. Člověk používá filtrování Monte Carlo, pokud ho zajímá, které faktory jsou nejvíce zodpovědné za generování vysokých/nízkých hodnot výstupu.

- Je zvažováno příliš mnoho modelových výstupů. To může být přijatelné pro zajištění kvality dílčích modelů, ale při prezentaci výsledků celkové analýzy by se tomu mělo zabránit.

- Citlivost po částech. To je, když člověk provádí analýzu citlivosti na jednom submodelu najednou. Tento přístup není konzervativní, protože by mohl přehlédnout interakce mezi faktory v různých dílčích modelech (chyba typu II).

- Běžně používaný přístup OAT není platný pro nelineární modely. Místo toho by měly být použity globální metody.

Metody analýzy citlivosti

Existuje velký počet přístupů k provádění analýzy citlivosti, z nichž mnohé byly vyvinuty k řešení jednoho nebo více výše uvedených omezení. Liší se také typem citlivosti, ať už na základě (například) rozkladových rozptylů , parciálních derivací nebo elementárních efektů . Obecně však většina postupů dodržuje následující osnovu:

- Kvantifikujte nejistotu v každém vstupu (např. Rozsahy, rozdělení pravděpodobnosti). Všimněte si toho, že to může být obtížné a existuje mnoho metod pro vyvolání distribucí nejistoty ze subjektivních dat.

- Identifikujte výstup modelu, který má být analyzován (cíl zájmu by v ideálním případě měl mít přímý vztah k problému, který model řeší).

- Spusťte model několikrát pomocí nějakého návrhu experimentů , diktovaného metodou výběru a nejistotou vstupu.

- Pomocí výsledných výstupů modelu vypočítejte požadované míry citlivosti.

V některých případech se tento postup bude opakovat, například u vysoce dimenzionálních problémů, kdy uživatel musí před provedením úplné analýzy citlivosti vyloučit nedůležité proměnné.

Různé typy „základních metod“ (diskutované níže) se odlišují různými měřenými senzitivitami. Tyto kategorie se mohou nějak překrývat. Mohou být uvedeny alternativní způsoby získávání těchto opatření za omezení problému.

One-at-a-time (OAT)

Jedním z nejjednodušších a nejběžnějších přístupů je změna jednoho faktoru v čase (OAT), aby se zjistilo, jaký účinek to má na výstup. OAT obvykle zahrnuje

- přesunutí jedné vstupní proměnné, udržení ostatních na jejich výchozích (nominálních) hodnotách, pak,

- vrácení proměnné na její nominální hodnotu, poté se opakuje pro každý další vstup stejným způsobem.

Citlivost lze poté měřit sledováním změn ve výstupu, např. Parciálními derivacemi nebo lineární regresí . To se jeví jako logický přístup, protože jakákoli změna pozorovaná ve výstupu bude jednoznačně způsobena změnou jediné proměnné. Kromě toho lze změnou jedné proměnné najednou ponechat všechny ostatní proměnné zafixované na jejich centrální nebo základní hodnoty. To zvyšuje srovnatelnost výsledků (všechny 'efekty' jsou počítány s odkazem na stejný centrální bod v prostoru) a minimalizuje šance na zhroucení počítačového programu, což je pravděpodobnější, když se současně změní několik vstupních faktorů. Modeláři často preferují OAT z praktických důvodů. V případě selhání modelu podle analýzy OAT modelář okamžitě ví, který je vstupní faktor zodpovědný za selhání.

Navzdory své jednoduchosti však tento přístup plně neprozkoumává vstupní prostor, protože nebere v úvahu současnou změnu vstupních proměnných. To znamená, že přístup OAT nemůže detekovat přítomnost interakcí mezi vstupními proměnnými.

Derivační lokální metody

Místní metody založené na derivátech zahrnují převzetí parciální derivace výstupu Y s ohledem na vstupní faktor X i :

kde dolní index x 0 naznačuje, že derivace je vzata v nějakém pevném bodě v prostoru vstupu (odtud „lokální“ v názvu třídy). Adjoint modeling and Automated Differiation are methods in this class. Podobně jako OAT se místní metody nepokoušejí plně prozkoumat vstupní prostor, protože zkoumají malé poruchy, obvykle jednu proměnnou najednou. Prostřednictvím Neural Networks je možné vybrat podobné vzorky z citlivosti založené na derivátech a provést kvantifikaci nejistoty.

Regresní analýza

Regresní analýza v kontextu analýzy citlivosti zahrnuje přizpůsobení lineární regrese odezvě modelu a použití standardizovaných regresních koeficientů jako přímých měřítek citlivosti. Regrese musí být lineární s ohledem na data (tj. Hyperplane, tedy bez kvadratických výrazů atd. Jako regresory), protože jinak je obtížné interpretovat standardizované koeficienty. Tato metoda je proto nejvhodnější, když je odezva modelu ve skutečnosti lineární; linearitu lze potvrdit například tehdy, je -li koeficient determinace velký. Výhodou regresní analýzy je, že je jednoduchá a má nízké výpočetní náklady.

Variantní metody

Metody založené na rozptylech jsou třídou pravděpodobnostních přístupů, které kvantifikují nejistoty vstupu a výstupu jako rozdělení pravděpodobnosti a rozkládají rozptyl výstupu na části, které lze přičíst vstupním proměnným a kombinacím proměnných. Citlivost výstupu na vstupní proměnnou se proto měří velikostí rozptylu na výstupu způsobeného tímto vstupem. Ty lze vyjádřit jako podmíněná očekávání, tj. S ohledem na model Y = f ( X ) pro X = { X 1 , X 2 , ... X k } je míra citlivosti i té proměnné X i dána jako ,

kde "Var" a " E " označují operátory rozptylu a očekávané hodnoty a X ~ i označuje sadu všech vstupních proměnných kromě X i . Tento výraz v podstatě měří příspěvek X i samotný k nejistotě (rozptylu) v Y (průměr z variací v jiných proměnných) a je známý jako index citlivosti prvního řádu nebo index hlavního účinku . Důležité je, že neměří nejistotu způsobenou interakcemi s jinými proměnnými. Další měřítko, známé jako index celkového účinku , udává celkový rozptyl v Y způsobený X i a jeho interakce s jakoukoli jinou vstupní proměnnou. Obě veličiny jsou obvykle standardizovány dělením Var ( Y ).

Metody založené na odchylkách umožňují úplné prozkoumání vstupního prostoru, účtování interakcí a nelineárních odpovědí. Z těchto důvodů jsou široce používány, pokud je možné je vypočítat. Tento výpočet obvykle zahrnuje použití metod Monte Carlo , ale protože to může zahrnovat mnoho tisíc modelových běhů, lze ke snížení výpočetních nákladů v případě potřeby použít jiné metody (například emulátory). Dekompozice úplných rozptylů mají smysl pouze tehdy, když jsou vstupní faktory na sobě nezávislé.

Variogramová analýza reakčních ploch ( VARS )

Jedním z hlavních nedostatků předchozích metod analýzy citlivosti je, že žádný z nich nebere v úvahu prostorově uspořádanou strukturu reakční plochy/výstupu modelu Y = f ( X ) v parametrickém prostoru. Využitím konceptů směrových variogramů a kovariogramů variogramová analýza reakčních ploch (VARS) řeší tuto slabinu rozpoznáváním prostorově spojité korelační struktury k hodnotám Y , a tedy i k hodnotám .

V zásadě platí, že čím vyšší je variabilita, tím heterogennější je reakční plocha v určitém směru/parametru v konkrétním měřítku poruchy. V rámci VARS lze tedy hodnoty směrových variogramů pro danou poruchovou stupnici považovat za komplexní ilustraci informací o citlivosti, a to propojením analýzy variogramu s koncepty směrových i poruchových stupnic. V důsledku toho rámec VARS zohledňuje skutečnost, že citlivost je koncept závislý na měřítku, a tím překonává problém rozsahu s tradičními metodami analýzy citlivosti. Ještě důležitější je, že VARS je schopen poskytovat relativně stabilní a statisticky robustní odhady citlivosti parametrů s mnohem nižšími výpočetními náklady než jiné strategie (o dva řády efektivnější). Je pozoruhodné, že se ukázalo, že existuje teoretické spojení mezi rámcem VARS a přístupy založenými na rozptylech a derivacích.

Promítání

Screening je konkrétní instancí metody založené na vzorkování. Cílem zde je spíše identifikovat, které vstupní proměnné významně přispívají k nejistotě výstupu ve vysoce dimenzionálních modelech, než přesně kvantifikovat citlivost (tj. Z hlediska rozptylu). Screening mívá ve srovnání s jinými přístupy relativně nízké výpočetní náklady a lze jej použít v předběžné analýze k vyčištění neinfluenciálních proměnných před aplikací informativnější analýzy na zbývající soubor. Jednou z nejčastěji používaných screeningových metod je metoda elementárních efektů .

Bodové grafy

Jednoduchým, ale užitečným nástrojem je vykreslení bodových grafů výstupní proměnné proti jednotlivým vstupním proměnným po (náhodném) vzorkování modelu přes jeho vstupní distribuce. Výhodou tohoto přístupu je, že se dokáže vypořádat také s „danými daty“, tj. Sadou libovolně umístěných datových bodů, a poskytuje přímou vizuální indikaci citlivosti. Kvantitativní míry lze také nakreslit, například měřením korelace mezi Y a X i , nebo dokonce odhadem opatření založených na rozptylech nelineární regresí .

Alternativní metody

K překonání některých výše diskutovaných omezení byla vyvinuta řada metod, které by jinak činily odhad opatření citlivosti (nejčastěji kvůli výpočetním nákladům ). Obecně se tyto metody zaměřují na efektivní výpočet měr citlivosti na základě rozptylu.

Emulátory

Emulátory (známé také jako metamodely, náhradní modely nebo povrchy odpovědí) jsou přístupy k modelování dat / strojového učení, které zahrnují vybudování relativně jednoduché matematické funkce, známé jako emulátor , která aproximuje chování vstupu a výstupu samotného modelu. Jinými slovy, je to koncept „modelování modelu“ (odtud název „metamodel“). Myšlenka je taková, že ačkoli počítačové modely mohou být velmi složitou řadou rovnic, jejichž řešení může trvat dlouho, mohou být vždy považovány za funkci jejich vstupů Y = f ( X ). Spuštěním modelu na několika bodech ve vstupním prostoru může být možné umístit mnohem jednodušší emulátor η ( X ) tak, že η ( X ) ≈ f ( X ) do přijatelného rozmezí chyb. Potom lze z emulátoru vypočítat míry citlivosti (buď s Monte Carlem, nebo analyticky), což bude mít zanedbatelné dodatečné výpočetní náklady. Důležité je, že počet běhů modelu potřebných k přizpůsobení emulátoru může být řádově menší než počet běhů potřebných pro přímý odhad míry citlivosti z modelu.

Je jasné, že jádrem emulátorového přístupu je najít η (emulátor), který je dostatečně blízkým přiblížením k modelu f . To vyžaduje následující kroky,

- Vzorkování (běh) modelu v několika bodech jeho vstupního prostoru. To vyžaduje ukázkový design.

- Výběr typu emulátoru (matematické funkce), který chcete použít.

- „Trénování“ emulátoru pomocí ukázkových dat z modelu - to obecně zahrnuje úpravu parametrů emulátoru, dokud emulátor co nejlépe napodobuje skutečný model.

Odběr vzorků modelu lze často provést pomocí sekvencí s nízkými nesrovnalostmi , jako je například sobolská sekvence -kvůli matematikovi Ilyovi M. Sobolovi nebo latinskému vzorkování hyperkrychlí , i když lze použít i náhodné návrhy, se ztrátou určité účinnosti. Výběr typu emulátoru a školení jsou vnitřně propojeny, protože trénovací metoda bude záviset na třídě emulátoru. Některé typy emulátorů, které byly úspěšně použity pro analýzu citlivosti, zahrnují:

- Gaussovy procesy (také známé jako kriging ), kde se předpokládá, že jakákoli kombinace výstupních bodů je distribuována jako vícerozměrná Gaussova distribuce . V poslední době se k řešení heteroscedastických a nesouvislých reakcí používají Gaussovy procesy „treed“ .

- Náhodné lesy , ve kterých se cvičí velké množství rozhodovacích stromů , a výsledek je zprůměrován.

- Posilování přechodů , kde se posloupnost jednoduchých regresí používá k vážení datových bodů k postupnému snižování chyb.

- Polynomiální chaos expanze , které používají ortogonální polynomy k aproximaci povrchu odezvy.

- Vyhlazovací splajny , běžně používané ve spojení se zkrácením HDMR (viz níže).

Použití emulátoru přináší problém strojového učení , což může být obtížné, pokud je odezva modelu vysoce nelineární . Ve všech případech je užitečné zkontrolovat přesnost emulátoru, například pomocí křížové validace .

Vysoce dimenzionální modelové reprezentace (HDMR)

Model reprezentace vysoké dimenzionální (HDMR) (termín je kvůli H. Raicova síť), je v podstatě emulátor přístup, který zahrnuje rozkládání výstup funkce na lineární kombinace vstupních podmínek a interakcí zvyšující rozměrnost. Přístup HDMR využívá skutečnosti, že model lze obvykle dobře aproximovat zanedbáním interakcí vyššího řádu (druhého nebo třetího řádu a výše). Termíny ve zkrácené řadě lze pak aproximovat např. Polynomy nebo splajny (REFS) a odpověď vyjádřit jako součet hlavních efektů a interakcí až do pořadí zkrácení. Z tohoto pohledu lze na HDMR pohlížet jako na emulátory, které zanedbávají interakce vysokého řádu; výhodou je, že jsou schopné emulovat modely s vyšší dimenzí než emulátory plného řádu.

Test citlivosti Fourierovy amplitudy (FAST)

Test citlivosti Fourierovy amplitudové citlivosti (FAST) používá Fourierovu řadu k reprezentaci vícerozměrné funkce (modelu) ve frekvenční oblasti pomocí jediné frekvenční proměnné. Integrály potřebné k výpočtu indexů citlivosti se proto stanou jednosměrnými, což má za následek výpočetní úspory.

jiný

Metody založené na filtrování Monte Carlo. Ty jsou také založeny na vzorkování a cílem zde je identifikovat oblasti v prostoru vstupních faktorů odpovídajících konkrétním hodnotám (např. Vysokým nebo nízkým) výstupu.

Aplikace

Příklady analýz citlivosti lze nalézt v různých oblastech použití, například:

- Environmentální vědy

- Podnikání

- Společenské vědy

- Chemie

- Inženýrství

- Epidemiologie

- Metaanalýza

- Multikriteriální rozhodování

- Časově kritické rozhodování

- Kalibrace modelu

- Kvantifikace nejistoty

Citlivý audit

Může se stát, že analýza citlivosti modelové studie má podpořit vyvozování a potvrdit její spolehlivost v kontextu, kde se odvozuje do politiky nebo rozhodovacího procesu. V těchto případech může být rámování samotné analýzy, její institucionální kontext a motivace jejího autora velmi důležitou záležitostí a čistě citlivou analýzu - s důrazem na parametrickou nejistotu - lze považovat za nedostatečnou. Důraz na rámování může mimo jiné pocházet z relevance politické studie pro různé obvody, které se vyznačují různými normami a hodnotami, a tedy z jiného příběhu o tom, „v čem je problém“ a především o tom, „kdo říká příběh'. Rámování nejčastěji zahrnuje víceméně implicitní předpoklady, které mohou být politické (např. Kterou skupinu je třeba chránit) až po technické (např. S kterou proměnnou lze zacházet jako s konstantou).

Aby byly tyto obavy řádně zohledněny, byly nástroje SA rozšířeny tak, aby poskytovaly posouzení celého procesu generování znalostí a modelů. Tento přístup byl nazýván „auditování citlivosti“. Inspirací je NUSAP, metoda používaná ke stanovení hodnoty kvantitativních informací při generování rodokmenů čísel. Podobně bylo vyvinuto auditování citlivosti, které poskytuje rodokmeny modelů a závěry založené na modelech. Citlivý audit byl navržen speciálně pro kontradiktorní kontext, kde nejen povaha důkazů, ale také míra jistoty a nejistoty související s důkazy budou předmětem stranických zájmů. Citlivostní audit je doporučen v pokynech Evropské komise pro posuzování dopadů a také ve zprávě Vědecké rady pro politiku evropských akademií.

Související pojmy

Analýza citlivosti úzce souvisí s analýzou nejistoty; zatímco posledně jmenovaný studuje celkovou nejistotu v závěrech studie, citlivostní analýza se pokouší identifikovat, jaký zdroj nejistoty více váží závěry studie.

Nastavení problému v analýze citlivosti má také silnou podobnost s oblastí navrhování experimentů . Při navrhování experimentů se studuje účinek nějakého procesu nebo intervence (dále jen „léčba“) na některé objekty („experimentální jednotky“). Při analýze citlivosti se díváme na vliv změny vstupů matematického modelu na výstup samotného modelu. V obou disciplínách se člověk snaží získat informace ze systému s minimem fyzických nebo numerických experimentů.

Viz také

- Kauzalita

- Metoda elementárních efektů

- Experimentální analýza nejistoty

- Testování citlivosti Fourierovy amplitudy

- Teorie rozhodování o informační mezerě

- Intervalový MKP

- Poruchová analýza

- Pravděpodobnostní návrh

- Analýza hranic pravděpodobnosti

- Robustifikace

- ROC křivka

- Kvantifikace nejistoty

- Rozdílová analýza citlivosti

Reference

Další čtení

- Cannavó, F. (2012). „Analýza citlivosti pro hodnocení kvality modelování sopečného zdroje a výběr modelu“. Počítače a geovědy . 44 : 52–59. Bibcode : 2012CG ..... 44 ... 52C . doi : 10,1016/j.cageo.2012.03.008 .

- Fassò A. (2007) „Analýza statistické citlivosti a kvalita vody“. In Wymer L. Ed, Statistický rámec pro kritéria kvality vody a monitorování . Wiley, New York.

- Fassò A., Perri PF (2002) "Analýza citlivosti". In Abdel H. El-Shaarawi a Walter W. Piegorsch (eds) Encyclopedia of Environmetrics , Volume 4, pp 1968–1982, Wiley.

- Fassò A., Esposito E., Porcu E., Reverberi AP, Vegliò F. (2003) „Analýza statistické citlivosti reaktorů s balenými kolonami pro kontaminovanou odpadní vodu“. Environmentální metrika . Sv. 14, č. 8, 743–759.

- Haug, Edward J .; Choi, Kyung K .; Komkov, Vadim (1986) Analýza citlivosti návrhu konstrukčních systémů . Matematika ve vědě a technice, 177. Academic Press, Inc., Orlando, FL.

- Pianosi, F .; Beven, K .; Freer, J .; Hall, JW; Rougier, J .; Stephenson, DB; Wagener, T. (2016). „Analýza citlivosti environmentálních modelů: Systematický přehled s praktickým pracovním postupem“ . Environmentální modelování a software . 79 : 214–232. doi : 10.1016/j.envsoft.2016.02.008 .

- Pilkey, OH a L. Pilkey-Jarvis (2007), Zbytečná aritmetika. Proč vědci v oblasti životního prostředí nemohou předvídat budoucnost. New York: Columbia University Press.

- Santner, TJ; Williams, BJ; Notz, WI (2003) Návrh a analýza počítačových experimentů ; Springer-Verlag.

- Taleb, NN, (2007) Černá labuť: Dopad vysoce nepravděpodobného, náhodného domu.

Zvláštní problémy

- Reliability Engineering & System Safety , 2003, 79: 121–2: SAMO 2001: Metodologické pokroky a inovativní aplikace analýzy citlivosti, editoval Tarantola S, Saltelli.

- Spolehlivé inženýrství a bezpečnost systému , svazek 91, 2006, zvláštní vydání o analýze citlivosti, editováno Helton JC, Cooke RM, McKay MD, Saltelli.

- International Journal of Chemical Kinetics 2008, Volume 40, Issue 11 - Special Issue on Sensitivity Analysis, edited by Turányi T.

- Reliability Engineering & System Safety , Volume 94, Issue 7, Pages 1133-1244 (July 2009), Special Issue on Sensitivity Analysis, edited by Andrea Saltelli.

- Reliability Engineering & System Safety , svazek 107, listopad 2012, Pokroky v analýze citlivosti, SAMO 2010, editoval Borgonovo E, Tarantola S.

- Journal of Statistical Computation and Simulation Volume 85, 2015 - Issue 7: Special Issue: Selected Papers from the 7th International Conference on Sensitivity Analysis of Model Output, July 2013, Nice, France, edited by David Ginsbourger, Bertrand Iooss & Luc Pronzato.

- Reliability Engineering & System Safety , svazek 134, únor 2015, editovali Stefano Tarantola a Nathalie Saint-Geours.

- Environmentální modelování a software , speciální vydání: Analýza citlivosti pro environmentální modelování (2021), Editoval Saman Razavi, Andrea Saltelli, Tony Jakeman, Qiongli Wu.

externí odkazy

- Joseph Hart, Julie Bessac, Emil Constantinescu (2018), „Analýza globální citlivosti pro parametry statistického modelu“, arXiv : 1708.07441

- webová stránka o analýze citlivosti- (Společné výzkumné středisko Evropské komise)

- SimLab , bezplatný software pro globální analýzu citlivosti Společného výzkumného centra

- MUCM Project -Rozsáhlé zdroje pro analýzu nejistoty a citlivosti výpočetně náročných modelů.